Kontroler Osądu – urządzenie do monitorowania wymiaru sprawiedliwości

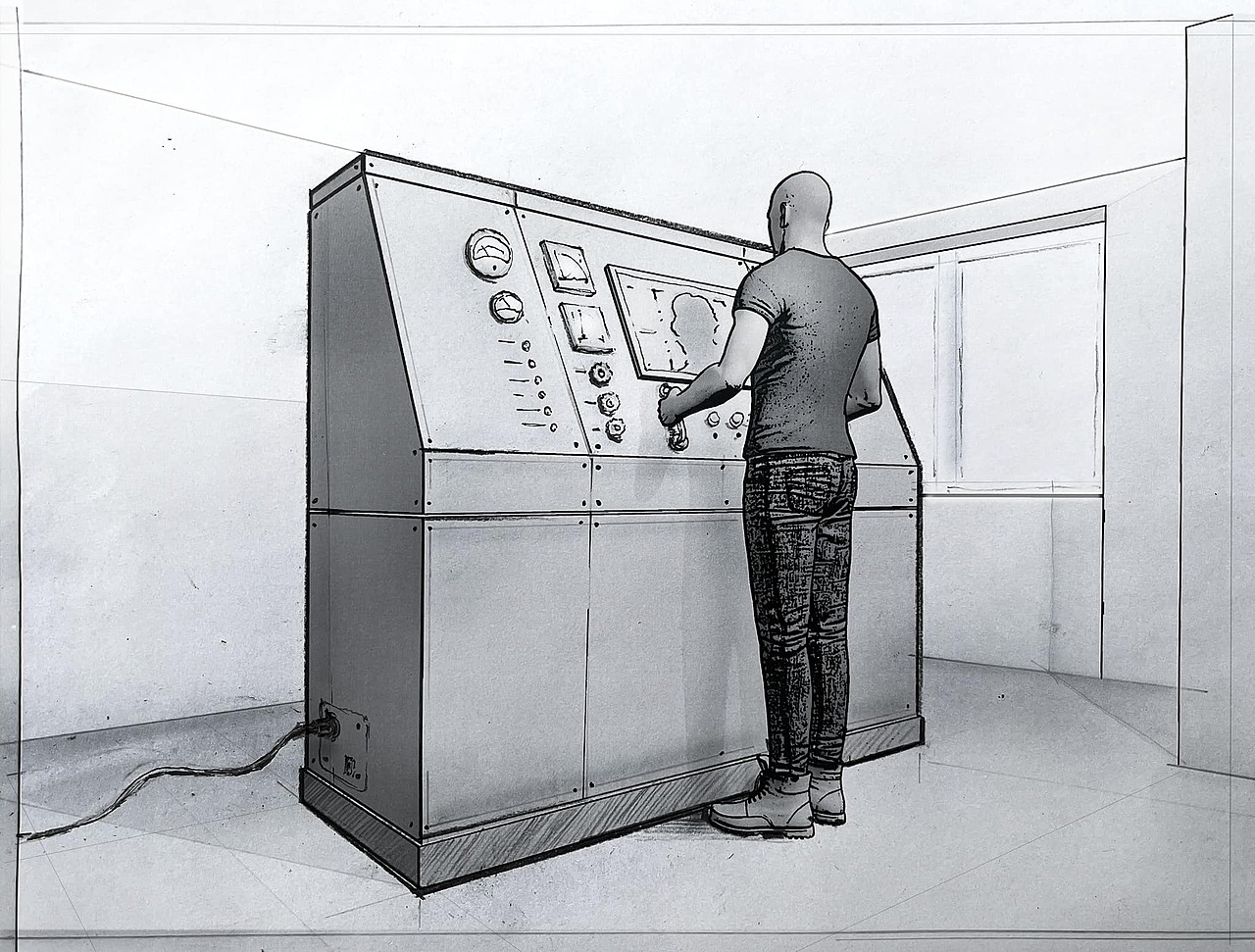

W erze sztucznych systemów „sztuczna sprawiedliwość” zdaje się wyznaczać granice etyki technologicznej. W miarę jak systematycznie oddajemy osąd nad naszymi zachowaniami społecznymi w ręce sztucznej inteligencji, nasze ludzkie poczucie dobra i zła staje się coraz bardziej powierzchowne. Ta powierzchowność nie wynika jednak z powszechności maszyn inteligentnych czy algorytmicznego podejmowania decyzji, lecz z długiej historii stosowania przez ludzkość systemów monitorowania moralności. Kontroler wymiaru sprawiedliwości czerpie z tej historii, badając, w jaki sposób wykorzystanie zaawansowanej technologii ujawnia paradoks eksternalizacji osądu moralnego i postaci autorytetu moralnego. KWS opiera się zarówno na subiektywności AI, jak i na ludzkich odniesieniach sprawiedliwości. Wszystkie te odniesienia, które określają moralne postępowanie i uprawnienia społeczne (wszystkie one są subiektywne i kulturowo stronnicze), zawierają wewnętrzny błąd, który urządzenie ujawnia na zasadzie „maszynistycznego kaprysu”. To, dlaczego coś jest uważane za sprawiedliwe lub niesprawiedliwe - lub, co ważniejsze, w jaki sposób decydujemy o czyjejś winie i karze – stanowi konfigurację niejasnych decyzji. Jak widać w wielu eksperymentach psychologicznych i wynikach badań nad technologią sprawiedliwości, decyzje te są zbyt często sprowadzane do abstrakcyjnych parametrów i miar używanych, oraz nadużywanych, przez społeczeństwo. Jest to szczególnie widoczne w eksperymencie Stanleya Milgrama, z którego „Kontroler” czerpie inspirację. W przeprowadzonym na początku lat sześćdziesiątych dwudziestego wieku eksperymencie Milgram badał, w jakim stopniu jednostki mogą być posłuszne wobec autorytetów, nawet jeśli wydawane im polecenia są moralnie wątpliwe lub wręcz szkodliwe dla innych. W ramach eksperymentu, pewien autorytet poinstruował uczestników badania (sędziów), aby za każdym razem, gdy w zadaniu pamięciowym uczniowie popełnią jakiś błąd, aplikowali im coraz silniejsze wstrząsy elektryczne. Pomimo nasilających się protestów i widocznego cierpienia uczniów, wielu uczestników nadal stosowało wstrząsy, jeśli autorytet ich do tego zachęcał. Pokazuje to, że zwykli ludzie są zdolni do wyrządzania krzywdy innym, jeśli prowadzi ich ktoś, kto jest dla nich autorytetem. Interaktywna maszyna - ucieleśnienie autorytetu i sędziego w jednym - Kontroler Wymiaru Sprawiedliwości wykorzystuje algorytmy sztucznej inteligencji do oceny prawdopodobieństwa popełnienia przestępstwa przez użytkownika, a następnie samodzielnie wymierza sprawiedliwość. Jego struktura przypomina fałszywy generator wstrząsów elektrycznych zbudowany przez Milgrama i może być sterowany za pomocą pokręteł, które odpowiadają płci, kolorowi skóry, statusowi ekonomicznemu, pochodzeniu etnicznemu, tożsamości seksualnej itp. W oparciu o te parametry technologia rozpoznawania twarzy prowadzi urządzenie do ostatecznego werdyktu w sprawie skłonności użytkownika do popełnienia przestępstwa, a następnie tych, których uzna za winnych, poraża impulsem elektrycznym. Parametry oceny, które decydują o stopniu „winy” użytkownika, decydują również o sile karnego impulsu elektrycznego. W ten sposób praca bezpośrednio nawiązuje do technologii sztucznej inteligencji wykorzystywanych w systemach wymiaru sprawiedliwości w USA i Chinach, a które obecnie są wciąż w fazie planowania w Europie. Interakcja z Kontrolerem Wymiaru Sprawiedliwości pozwala na doświadczalną konceptualizację tych technologii, a zwłaszcza losowości algorytmicznego podejmowania decyzji, którego implikacje dla nadzoru nad społeczeństwem zwykliśmy ignorować. Jak wskazuje Jon Fasman, autor „We See It All”, wykorzystanie technologii obserwacji operacyjnej - w tym technologii rozpoznawania twarzy, automatycznego odczytu tablic rejestracyjnych, dronów i algorytmów predykcyjnych - budzi poważne obawy dotyczące prywatności, wolności i praw obywatelskich. Włączenie tych technologii do arsenału organów ścigania wymaga krytycznego zbadania ich implikacji moralnych, prawnych i politycznych. Podstawową kwestią jest to, w jaki sposób technologie te wpływają na prawa jednostki i bezpieczeństwo publiczne. Fasman podkreśla również potrzebę nowelizacji przestarzałych przepisów prawa regulujących kwestie prywatności, pierwotnie zaprojektowanych na potrzeby ery przedcyfrowej, w celu sprostania nowym wyzwaniom stawianym przez nowoczesne narzędzia nadzoru. Istnieje również głęboka obawa o możliwość niewłaściwego wykorzystania tych technologii przez rządy, co może być źródłem poważnego zagrożenia dla swobód obywatelskich. Nadzór AI jest znany z nieodłącznej stronniczości cechującej wiele jej algorytmów, często odzwierciedlającej i wzmacniającej istniejące uprzedzenia społeczne, co prowadzi do dyskryminacji lub nieproporcjonalnego ukierunkowania na „określone” grupy społeczne i osoby. Technologia rozpoznawania twarzy wykazuje wyższe wskaźniki błędów dla osób kolorowych, co rodzi poważne pytania o jej rzetelność i dokładność. Ale to nie wszystko. Algorytmy predykcyjne w organach ścigania zaprojektowane w celu prognozowania aktywności przestępczej w oparciu o dane historyczne utrwalają nadmierny nadzór nad niektórymi grupami społecznymi. Powszechny brak uwzględnienia czynników społeczno-ekonomicznych i systemowych, które przyczyniają się do skrzywionej interpretacji danych, skutkuje podejściem represyjnym i uprzedzeniami w sprawach karnych. Rodzi to istotne pytania moralne i prawne dotyczące roli sztucznej inteligencji w utrwalaniu istniejących nierówności, ale także nieudanej skuteczności osądu moralnego.

Ania Malinowska